Voici une expression que l’on entend à peu près tous les jours, sans trop savoir de quoi il s’agit, voire en redoutant un peu ce qui se cache derrière. Un monstre ? Un gros ordinateur ? Un logiciel ultrapuissant ? Un cerveau incontrôlable ? des professeurs Nimbus enfermés dans leur laboratoire ? Un peu de tout cela, en fait.

Comment définir l’intelligence artificielle ? That is the question !

Depuis que l’IA existe – environ 60 ans -, les définitions ont énormément varié !

Le terme désigne un certain type de programmes informatiques qui permettent de simuler des capacités humaines comme la perception et la reconnaissance de formes, d’images, de sons, la traduction automatique, le dialogue homme/machine… Ils peuvent être implémentés sur différents appareils : des serveurs, des téléphones, des enceintes, des moteurs de recherche ou encore des robots. À côté de l’IA symbolique, dont le programme s’appuie sur des règles définies par un humain, cette approche est aujourd’hui peu utilisée, la machine learning se révélant bien plus efficace dans de nombreux cas. II consiste à traiter des masses des données grâce à des algorithmes. Un algorithme n’est rien d’autre qu’une « recette », c’est-à-dire une suite d’instructions bien précises destinées à transformer des « ingrédients » (les données brutes) en un « plat » déterminé (le résultat).

Machine Learning

Il correspond à l’apprentissage automatique. Le programme apprend seul, en étudiant des exemples, à reconnaître des images, des sons. Le deep learning ou apprentissage profond, souvent assimilé à l’IA par abus de langage, n’est qu’une partie du machine learning. Il s’appuie sur un réseau de dizaines ou centaines de couches de milliers de neurones artificiels, inspirés du cerveau humain.

Le fonctionnement des neurones numériques s’inspire de celui des neurones biologiques : ces derniers reçoivent des signaux électriques des neurones qui leur sont connectés. En réponse, ils envoient, par un neurotransmetteur à savoir l’Acétylcholine, un signal dans l’axone qui les relie au neurone suivant. Le neurone artificiel mime ce comportement par une fonction mathématique.

Le deep learning se déroule en deux phases. La première est l’apprentissage : pour apprendre à l’algorithme à reconnaître, par exemple, un bébé, on lui donne en entrée une photo de bébé, étiquetée comme telle. À chaque couche du réseau correspond un aspect particulier de l’image : angle de l’oreille, forme de l’œil, cheveux… Si l’on indique à l’algorithme qu’il a mal identifié le nourrisson, il fait varier lui-même les poids et les seuils des connexions pour les renforcer ou les éliminer, jusqu’à trouver le résultat correct. Cette opération est répétée avec des milliers de photos de nouveau-nés.

Le programme ayant acquis la notion de ce qu’est un bébé, il peut alors faire de la prédiction : lorsqu’on lui présente une image qu’il n’a jamais vue, il sait repérer le bébé.

On associe parfois robots et IA…Il est vrai que l’intelligence artificielle peut s’incarner physiquement dans les robots, notamment pour l’assistance aux personnes, mais la plupart des robots industriels actuels se contentent de répéter des séquences, sans qu’intervienne aucune technique d’IA.

Dans le développement de l’IA la véritable charnière a été la démocratisation du web, au début des années 2000, lorsque la quantité de données disponibles a explosé. Tous les algorithmes développés depuis des décennies ont trouvé alors un énorme champ d’application, avec des enjeux économiques et sociaux colossaux. Ce n’est pas un hasard si les grands de l’IA aujourd’hui dans l’industrie sont les GAFAM (Google, Apple, Facebook, Amazon, Microsoft) ou leurs équivalents chinois, les BATX, des opérateurs du web ; ils disposent de tombereaux de données.

Dans son projet géopolitique la Chine représente la puissance technologique, tandis que l’Europe est larguée, c’est une colonie technologique.

Le destin des données : une inquisition !

Explorant les quantités astronomiques de données qu’elles aspirent, notamment via les réseaux sociaux, ces entreprises connaissent nos goûts, nos habitudes, nos comportements, nos envies, notre religion, notre partie politique… Dans notre monde très consumériste, l’IA est utilisée et exploitée comme un véritable « détecteur de désirs ». Elle met ensuite en avant et spécifiquement les arguments qui pourraient nous séduire. C’est le « levier de la récompense ». Elle s’adresse personnellement à chacun de nous, cible chaque individu en fonction de ce qu’elle sait de lui.

En Chine, dans certaines enseignes de fast-food, une application reconnaît le client dès qu’il approche et lui propose aussitôt un menu personnalisé. S’il sourit, cela vaut commande et le paiement s’effectue automatiquement. L’intelligence artificielle constitue une véritable intrusion dans l’espace intime. Des modèles économiques sont désormais fondés sur cette exploitation des données.

C’est ainsi que, l’intelligence artificielle confère aux GAFAM, acronyme apparu au milieu des années 2000 sous la forme GAFA (représenté par la lettre initiale des cinq entreprises : Google, Apple, Facebook, Amazon et Microsoft), ils disposent d’un pouvoir sans limite. Ils peuvent même faire élire un président d’un pays dit démocratique.

Ce n’est pas la technologie qui est à craindre, mais le type d’intentions qui motivent son usage.

Détourné à des fins mercantiles ou sécuritaires voire politiques, ce formidable outil représente une menace pour chaque individu.

C’est ainsi Zuckerberg imagine pouvoir ainsi satisfaire tous nos désirs avant même que nous en ayons conscience.

Contrôler les pensées et donc contrôler les masses, grâce à l’intelligence artificielle, serait un scénario possible.

Il faut savoir rester inquiet – au sens étymologique : ne pas être en repos (quiet en anglais). Lorsque l’IA va bouleverser notre existence, créer de nouvelles conditions de vie dans la société… Mais aussi parce qu’elle est faite par des humains, et que certains d’entre eux peuvent être tentés de l’utiliser de façon plus ou moins malveillante. Il reste à nous montrer très vigilant et sur nos gardes d’une part, vis-à-vis des pouvoirs publics. Il suffit de faire référence à la Chine : la mise en place d’une surveillance généralisée avec reconnaissance faciale, aboutissant à un « score de réputation », qui présente un impact très fort sur la vie.

Dans ce cas extrême mais bien réel, l’intelligence artificielle devient une arme contre les libertés individuelles, au service d’un contrôle social total. Même les démocraties, elles ne sont pas à l’abri de cette inquisition. Quant aux grands acteurs de l’internet, ils peuvent s’appuyer sur leur extraterritorialité pour faire quasiment ce qu’ils veulent… Dans cet univers où tout le monde pourrait lire dans les pensées, l’individu serait un livre ouvert sans jardin secret.

Le patron de Facebook y voit une aubaine de consommateur. Comme le cerveau génère des ondes électromagnétiques, on pourrait facilement établir une corrélation entre certaines ondes et le désir. Faut-il se réjouir que ces élucubrations ne soient que des supputations pour le moment !

Quand Satan fait irruption !

Une chose ressort, pourtant, aux possibilités offertes par l’I.A : les hommes ont l’art de tout détourner à des fins immorales, scandaleuses ou destructrices, voire autodestructrices.

L’intelligence artificielle est capable de prouesses incroyables ? Elle est de plus en plus performante ! On l’applique à la lutte contre ses adversaires en répandant la rumeur, multipliant les coups tordus et les scandales. Elle est puissante et enthousiasmante ? Elle devient une arme de déstabilisation dans les campagnes politiques (en recourant aux boucs émissaires contre le chef ou le groupe), les attaques économiques, où elle fait des ravages et peut mettre à terre un ennemi sans merci et sans morale.

Elle est au service des lobbies pharmaceutiques qui ont à leur service d’excellents visiteurs médicaux en la personne de certains journalistes ou de médecins hypermédiatisés.

Outre la question du consentement (les personnes concernées ayant rarement accepté que leur image soit détournée), la multiplication de deepfakes de plus en plus sophistiqués pose un défi de taille aux médias et aux citoyens. Comment garantir la véracité de l’information ? Toutes les mani pulations sont en effet envisageables. Bientôt, les vidéos pourront être facilement manipulées par qui conque, sans aucune expertise. Il est important que les gens sachent que c’est possible. D’autant que la technologie n’attend pas la législation pour avancer. Déjà en mesure de copier les expressions d’un visage, le deep learning permet désormais de reproduire les mouvements d’un corps pour, par exemple, faire danser Donald Trump sur un air d’opéra !

« Sans contre-mesures défensives, l’intégrité des démocraties du monde entier est menacée » affirme Giorgio Patrini, fondateur et PDG de Deeptrace.

Pourtant, rêvons un peu… L’intelligence artificielle devrait permettre exclusivement à la communauté des hommes de s’élever toujours plus et de lutter contre des fléaux sacrément plus dangereux qu’un concurrent dans une campagne politique. Imaginons un peu cette technologie au service de la médecine, la recherche, la lutte contre les virus, le développement de cultures pour prévenir la famine et assurer l’éducation, l’échange des savoirs… Une technologie au service de l’humanité, pas de sa destruction.

Toute cette machine est déjà en route, et des entreprises, des ingénieurs travaillent à l’émancipation des hommes et à leur espérance de vie. C’est ainsi qu’on a appris que les ordinateurs quantiques pouvaient effectuer en trois minutes un calcul qui prendrait dix mille ans à des super-ordinateurs classiques. C’est une puissance phénoménale, à la fois vertigineuse et enthousiasmante. Puisse cette intelligence artificielle être mise à la disposition du genre humain, non pour le détruire mais pour l’élever. Non pour l’anéantir mais pour le préserver. Non pour le déstabiliser mais pour le mettre en valeur. Cela passera aussi, et avant tout, par l’éducation.

La recherche médicale

L’intelligence artificielle peut vampiriser tous les secteurs de la vie dés lorsqu’elle y trouve un intérêt et peut élargir son pouvoir. C’est ainsi que la Santé, le domaine privilégié des humains, représente une belle cible.

Tout logiquement il reste à en prendre possession, comme on va à la conquête d’une citadelle. Evidemment, chaque membre de la hiérarchie ne doit pas oublier qu’il est sous la coupe des lobbies pharmaceutiques lesquels, leur seront reconnaissants.

La production littéraire des professeurs et médecins élus sera privilégiée. Avec l’appui des animateurs et des producteurs des différents grands média leur livres deviendront des best-sellers ! Certains médecins, promus grâce à leurs réseaux deviennent des stars, quant aux praticiens qui s’adonnent à une médecine de terrain, composée de remèdes naturels, seront sous le boisseau et bien souvent rayés de de l’ordre des médecins. Et pourtant ce sont eux qui participent à l’évolution de la véritable médecine qui doit rester humaine et non polluante.

Dans une telle situation, plutôt ambiguë, qu’en est-il de l’IA ?

La rénovation de l’intelligence transforme notre quotidien…sans que nous maîtrisions toutes les conséquences. Elle assiste déjà les médecins dans leur diagnostic, en réalisant des algorithmes dont l’application permet de gagner un temps précieux et peut être propose une thérapie allopathique qui comblera de satisfactions Big Pharma.

Les données de santé pour un suivi personnalisé

Le numérique et le traitement du diabète font si bon ménage qu’ils ont donné naissance à un concept original, s’appliquant bien au-delà de cette seule affection : le digitosome qui regroupe la somme des données numériques (digital en anglais) qu’une personne génère en ligne et qui sont pertinentes pour sa maladie) : tension, activité physique ou cardiaque enregistrées par une montre connectée, informations renseignées sur le smartphone (alimentation, sommeil) …

Autant de données qui peuvent être exploitées par des IA pour personnaliser le suivi et les soins. Dans le diabète, en effet, l’incapacité de l’organisme à réguler le taux de sucre dans le sang (glycémie), entraîne des hyperglycémies délétères à moyen terme. Cette maladie implique beaucoup le patient, car il doit mesurer sa glycémie en prélevant une goutte de sang, faire attention à chaque repas, etc. C’est ainsi qu’aujourd’hui, le patient diabétique est déjà le plus connecté en moyenne.

Finalement, l’enjeu consiste à créer des algorithmes qui agrègent en continu les données des patients. Le tout centralisé sur un smartphone ou envoyé au cabinet médical. L’IA apprend ainsi à prévenir le médecin en cas d’anomalie.

Mais la recherche va plus loin désormais, en s’intéressant même… aux messages postés sur les réseaux sociaux ! Ils permettent d’identifier les personnes qui se battent et vivent mal leur maladie, ou les causes d’un stress, d’une fatigue qui nuit à la prise en charge.

Le patient ne s’en ouvre pas forcément à son médecin, par manque de temps ou parce que cela ne lui semble pas pertinent. Mais tout ce qui dégrade la qualité de vie est susceptible d’avoir un impact sur le diabète.

Ces données pourraient être utilisées dans bien d’autres pathologies. Des chercheurs de l’université de Pennsylvanie ont ainsi montré que le recours à Facebook permettait de détecter jusqu’à 21 problèmes ou causes différentes ! Dépression, alcoolisme, hypertension, cholestérol, maladies respiratoires, Alzheimer, cancer… Et cela à partir de l’analyse de 20 millions de mots postés par 999 personnes.

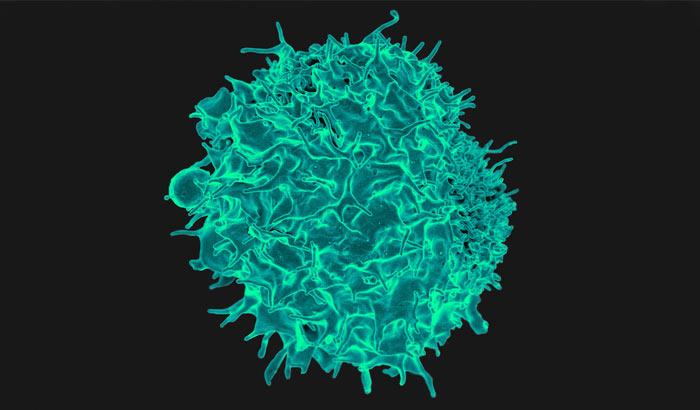

Des cancers bientôt révélés par « l’imagerie intelligente » ?

Nourri de milliers d’images de tumeurs, un algorithme analyse la composition moléculaire de tissus radiographiés. Prédire l’apparition d’une tumeur avant qu’elle ne soit visible à l’imagerie : c’est la dernière prouesse de l’intelligence artificielle en matière de santé. Un algorithme, présenté dans la revue Radiology, a été capable d’identifier, sur des radiographies de tissus mammaires en apparence sains, la zone précise où se développerait un cancer quatre ans plus tard.

Pour parvenir à une telle précision, les chercheurs ont enrichi un système de deep learning de 72 000 mammographies en les associant aux données cliniques évaluant le risque de cancer du sein (alimentation, génétique, hormones, poids, grossesses, allaitement…) de 30 000 patientes. L’algorithme a ainsi pu accéder à de nouveaux niveaux de lecture sur le cliché.

En oncologie, en particulier, « l’imagerie intelligente » permettrait de caractériser l’agressivité d’un cancer sans recourir à la biopsie. Ce prélèvement de tissu tumoral, sert à analyser au microscope et par séquençage génétique les profils moléculaires des cellules cancéreuses. Avec la radiomique, cet examen fastidieux est réduit aux quelques secondes de la prise et de l’analyse automatique du cliché médical. II « suffit » pour cela d’entraîner une machine en lui montrant des centaines ou des milliers d’images de tumeurs (poumon, peau, sein…) à différents stades, en renseignant à chaque fois les données correspondantes d’analyses cliniques, génomiques ou autres. L’IA apprend ainsi à repérer, sur de nouvelles images, les caractéristiques biologiques d’un cancer.

La chirurgie assistée par robot

De part de ma formation de chirurgien, œuvrant plus spécifiquement sur les champs de bataille (16 seize guerres à mon actif) j’ai été intéressé en un premier temps à la chirurgie mini-invasive (CMI) qui permet de réduire le temps de récupération, la douleur et les complications. Elle fait figure de révolution, elle se développera plus tard tandis que les chercheurs concentreront leurs études sur la fabrication de robots chirurgicaux. Aujourd’hui, la CMI peut être accomplie avec l’aide d’assistants robotiques. Le chirurgien bénéficie d’une vision 3D « grossie » du site opératoire et contrôle le robot grâce à une interface de télé-opération. La mission du robot chirurgical est d’améliorer la précision, la flexibilité et le contrôle du praticien.

Si de tels système peuvent être plus rapides et précis que l’œil humain, ils ne sont cependant pas utilisés pour remplacer les chirurgiens, mais pour fournir une assistance efficace.

De plus, après deux décennies d’utilisation, ses avantages significatifs restent encore flous. En 2018, la chirurgie télécommandée n’a encore été réellement expérimentée que sur des porcs. Même si, les résultats sont prometteurs, l’idée d’utiliser des systèmes robotiques totalement autonomes pour la chirurgie est controversée d’un point de vue social et éthique. Des problèmes liés à l’espace de travail, à la précision de la machine ou à des erreurs de son système sensoriel pourraient en effet s’avérer potentiellement fatals pour le patient.

J’ai rêvé un moment de me procurer un tel système robotique, mais son coût (2 millions d’euros) et son inaccessibilité pour un chirurgien de brousse m’y a fait renoncer ! L’intervention de télé chirurgie depuis Paris en opérant des dizaines de blessés en Syrie, en Libye, au Mali reste aujourd’hui un leurre ! Il faut continuer à aller au charbon et subir sur le terrain le fracas et le jaillissement des larmes.

Une I.A pour identifier l’Alzheimer

Un algorithme de détection précoce de la maladie d’Alzheimer aurait identifié 100 % des cas lors de premiers tests à petite échelle. La maladie d’Alzheimer représente une véritable course contre la montre aux neurologues quand on a posé le diagnostic en disposant de tous les symptômes : « la perte de volume cérébral est tellement importante qu’il est trop tard pour intervenir », explique le radiologue Jae Sohn qui a ourdi alors de développer un algorithme apte à prévoir l’apparition de la maladie bien plus tôt que les méthodes classiques.

Cet algorithme fait appel à des images simulant le métabolisme du glucose dans le cerveau, lequel est perturbé lors du diabète, mais dans une approche subtile et difficile à identifier. Recourant à des procédures d’apprentissage profond (deep learning), les chercheurs l’ont entrainé à reconnaitre les profils problématiques. Pour cela, ils ont eu recours aux dossiers médicaux de plus de 1000 patients suivis pendant plusieurs années.

Après cette phase de réglage, l’algorithme a été testé sur un échantillon indépendant de 40 patients, dont le suivi médical était connu. Le résultat fut inespéré : l’algorithme a identifié tous ceux qui allaient développer la maladie, en s’appuyant sur les images réalisées plus de six ans avant le diagnostic final. Il reste à expérimenter sur de plus grandes cohortes, ainsi cet algorithme pourrait constituer un outil de diagnostic précieux. Mais attendons !

Les limites d’«Homo numéricus»

« Le poisson rouge, qui découvre un nouveau monde à chaque tour de bocal, est capable de fixer son attention jusqu’à huit secondes » constate Bruno Patino dans son roman « la civilisation du poisson rouge » Ed. Grasset

L’« Homo numéricus », né avec un écran tactile au bout des doigts, fait à peine mieux : il peut se concentrer neuf secondes avant qu’un nouveau stimulus, une autre alerte, une énième notification de son smartphone, ne détourne son attention. Ce sont les ingénieurs de Google qui ont fait cette comparaison affolante : ceux-là mêmes qui, prêtres vaudous de la civilisation des écrans, sont les premiers responsables de notre zombification. Cherchez l’erreur. Nous sommes donc tous des poissons rouges, « enfermés dans le bocal de nos écrans ». Des morts-vivants, hypnotisés par les sorciers qui ont fait profession de détourner un vieil adage : « Votre temps, c’est notre argent ». L’économie de l’attention, fondée sur les mêmes ressorts stroboscopiques de dépendance que les casinos, est en train de réduire l’humanité en esclavage. C’est le récit d’une tragédie. Comment l’utopie libertaire des débuts d’internet s’est fracassée sur le mur de l’argent avant de s’embourber dans les sables de l’addiction déversés par les nouveaux empires numériques. Il y a de quoi se désoler d’autant plus des comportements prédateurs pervers (le triomphe des fake news devenus une manifestation spectaculaire) qui dominent à présent ce qu’on entrevoyait jadis comme un monde idéal.

L’effondrement du Q.I

Des experts en pédagogie et anthropologie constatent depuis quelques années la chute du quotient intellectuel des jeunes plongés des heures durant devant leurs smartphones. Cette observation pourrait sembler paradoxale : acquérir une grande variété de connaissances à bon compte, ne peut que stimuler l’intelligence et la créativité. Et pourtant !

Des tests psychologiques nous montrent que certaines formes de mémoire disparaissent. Va-t-on tous devenir débiles !… C’est la conclusion à la lecture des publications scientifiques qui indiquent que notre QI diminue. Mais ce n’est pas pour autant qu’on devient débile. Si le QI diminue, c’est le témoignage que nous utilisons autre ment notre intelligence. La mémoire dite “de travail” diminue puisqu’il n’est pas nécessaire de retenir le numéro de téléphone ou le code d’entrée de mes amis. Alfred Binet a inventé le QI à une époque où l’on avait besoin d’avoir une cartographie de l’école, de montrer des performances. Au tournant du XXe siècle, c’était un indicateur. Aujourd’hui que le QI diminue, c’est la preuve que les humains sont en train de s’adapter. La mémoire dite sémantique est en train de disparaître au profit d’une mémoire procédurale ? « Certaines formes de mémoire émergent alors que d’autres disparaissent. Notre mémoire de travail, que nous utilisions avant l’invention de 1’écriture, a été diminuée par trois depuis que nous avons consigné des informations sur des tablettes en argile » constate le Pr P.M Lhedo, directeur du département neurosciences à l’Institut Pasteur.

« Notre cerveau se modifie à chaque fois que nous vivons des révolutions. Mais c’est un organe extrême ment énergivore, et il faut laisser aussi d’autres systèmes fonctionner. C’est une des raisons pour laquelle notre cerveau est partiellement sorti de la boîte crânienne au début des années 1950, avec ce que l’on appelle l’intelligence artificielle. À l’époque de Néandertal, on avait externalisé notre squelette en inven tant des outils, le propulseur, par exemple, pour le javelot. Autre externalisation, la révolution industrielle : on invente la machine, qui n’est rien d’autre que le muscle. Elle produit de la chaleur et du travail. Avec la 3e externalisation, c’est le cognitif qui est externalisé dans des ordinateurs et des algorithmes. Le changement n’est donc plus climatique ou lié à l’invention du feu ou de l’écriture, c’est le digital qui produit en permanence des changements disruptifs ».

Nous faisons de plus en plus souvent appel à l’IA pour nous faciliter la vie. Quel effet cela a-t-il sur notre cerveau ? Dans une société intégralement régie par l’IA, perdrions-nous toutes nos capacités cognitives ?

Pour limiter la casse, tout d’abord il faut rester maitre de l’IA, et pour cela prendre de la distance afin d’observer son fonctionnement… et même de la tester.

Parce que se laisser conduire par la machine qui nous dicte nos préférences sans comprendre les mécanismes sous-jacents… voilà la faille ! Avec en perspective l’émergence de deux « classes cognitives », notamment en milieu scolaire : d’un côté des enfants plutôt favorisés qui seraient actifs vis-à-vis de l’IA, (leurs décisions plus réfléchies requièrent du raisonnement, des stratégies de résolution du problème et de planification), et, d’autres, moins éduqués, qui en consommeraient de manière passive et pourraient, se trouver sous l’influence d’une IA propagatrice d’idéologie. La machine prend des décisions à leur place.

Peut-on se passer de l’IA ?

Nous sommes condamnés à vivre avec. Reconnaissons qu’il devient de plus en plus difficile de se passer d’internet, même pour payer ses impôts ! Or, qui dit numérique dit, pour les années à venir, techniques d’intelligence artificielle. Voilà pourquoi il faut impérativement imposer une autonomie du sujet et éviter que la machine prenne le dessus, ce qui est un vrai risque. Cela dépend de nous, individuellement et collectivement. Là encore, il n’y a pas de fatalité. Dans le domaine de la santé, les médecins qui ont réfléchi à la révision des lois de bioéthique l’exigent : une machine peut suggérer un diagnostic, mais c’est toujours le praticien qui, in fine, en prend la responsabilité.

Le premier fantasme à écarter est celui de la super intelligence : les systèmes nous deviendraient supérieurs et finiraient par nous éliminer. On en est loin ! Plus sérieusement, je pense que ces craintes concernent avant tout les différents lobbies, les inégalités, les prérogatives communautaires, les biais que peuvent contenir les systèmes. Une autre inquiétude porte sur le respect de la vie privée. Que fait-on de mes données ? Une question qui concerne l’ensemble des systèmes numériques, et sur laquelle il faut rester vigilants.

N’oublions pas que « tout ce qui compose la personne, l’esprit critique, la créativité, l’intuition, l’émotion, les états d’âmes… ne sont pas à la portée d’un robot ».

Je vous recommande le livre de Daniel Battu « Bien vieillir et augmenter son espérance de vie, grâce au numérique ». Ed. Bookelis : 14 €

Nous le savons depuis toujours : le vieillissement est inéluctable. Et c’est à partir de 50 ans que la « Silver Economy », ou « l’économie des cheveux blancs », prend ce public pour cible. A compter de la cinquantaine, nous devenons en effet des seniors potentiels, qui répondent à des critères de consommation et des besoins spécifiques.

Les progrès accomplis dans le domaine de la santé expliquent l’allongement de l’espérance de vie. Mais bientôt, la prise en charge des seniors va s’avérer de plus en plus difficile, du fait du nombre de ceux-ci et des coûts sociaux induits. Une prise en charge personnelle de la santé des seniors s’impose, et celle-ci doit être organisée le plus tôt possible, c’est-à-dire vers la cinquantaine, afin que chacun prenne l’habitude de s’organiser pour « Bien Vieillir ».

Fort heureusement, l’information de prévention médicale est à portée de main, chez le médecin traitant, chez le pharmacien local, dans l’environnement social, ainsi que sur Internet en sélectionnant à la fois les procédures nécessaires de protection et les sites d’information les plus pertinents. A côté de la médecine conventionnelle, payante et plus ou moins remboursée, des services parallèles de soins et de prévention sont aussi disponibles. Même si la tentation est forte, attention aux mélanges nocifs !